⚙️ O que são ferramentas?

As ferramentas são pequenos scripts de Python que adicionam superpotências ao seu LLM. Quando ativado, eles permitem que seu chatbot faça coisas incríveis - como pesquisar na web, raspar dados, gerar imagens, voltar a usar as vozes da IA e muito mais.

Pense nas ferramentas como plugins úteis que sua IA pode usar ao conversar com você.

🚀 O que as ferramentas podem me ajudar a fazer?

Aqui estão apenas alguns exemplos de quais ferramentas permitem que seu assistente de IA faça:

- 🌍 Pesquisa na Web: Obtenha respostas em tempo real pesquisando a Internet.

- 🖼️ Geração de imagem: Crie imagens a partir de seus prompts.

- 🔊 Saída de voz: gerar vozes de IA usando o Elevenlabs.

Explore as ferramentas prontas para uso aqui:

Mostra as ferramentas

📦 Como instalar ferramentas

Existem duas maneiras fáceis de instalar ferramentas no Webui aberto:

- Vá paraBiblioteca de ferramentas comunitárias

- Escolha uma ferramenta e clique no botão Get.

- Digite o endereço IP ou URL da sua instância do Web.

- Clique em "Importar para Webui" - Concluído!

🛑 Dica de segurança: nunca importe uma ferramenta em que você não reconheça ou confie. Estes são scripts Python e podem executar o código inseguro.

🔧 Como usar as ferramentas em webui aberto

Depois de instalar ferramentas (mostraremos como abaixo), veja como habilitá -las e usá -las:

Você tem duas maneiras de ativar uma ferramenta para o seu modelo:

➕ Opção 1: Ativar na janela de bate -papo

Enquanto conversava, clique no ícone ➕ na área de entrada. Você verá uma lista de ferramentas disponíveis - você pode ativar qualquer uma delas em tempo real para essa sessão.

💡 Dica: ativar uma ferramenta fornece ao modelo permissão para usá -lo - mas pode não usá -lo, a menos que seja útil para a tarefa.

✏️ Opção 2: Ativar por padrão (recomendado para uso frequente)

- Vá para: Workspace ➡️ Modelos

- Escolha o modelo que você está usando (como GPT-4 ou LLAMA2) e clique no ícone de edição de edição.

- Role para baixo até a seção "Ferramentas".

- ✅ Verifique as ferramentas às quais você deseja que seu modelo tenha acesso por padrão.

- Clique em Salvar.

Isso garante que o modelo sempre tenha essas ferramentas prontas para uso sempre que você converse com ele.

Você também pode deixar seu LLM selecionar automaticamente as ferramentas certas usando o filtro AutoTool:

🎯 Nota: Mesmo ao usar o AutoTool, você ainda precisa ativar suas ferramentas usando a opção 2.

✅ E é isso-seu LLM agora é movido a ferramentas! Você está pronto para sobrecarregar seus bate -papos com a pesquisa na web, geração de imagens, saída de voz e muito mais.

🧠 Escolhendo como as ferramentas são usadas: padrão vs nativo

Depois que as ferramentas estão ativadas para o seu modelo, o Nullcore oferece duas maneiras diferentes de permitir que seu LLM as use em conversas.

Você pode decidir como o modelo deve chamar ferramentas escolhendo entre:

- 🟡 Modo padrão (baseado em prompt)

- 🟢 Modo nativo (chamada de função interna)

Vamos quebrá -lo:

🟡 Modo padrão (acionamento de ferramentas com base no rápido)

Esta é a configuração padrão no webui aberto.

Aqui, seu LLM não precisa suportar a chamada de funções de suporte nativamente. Em vez disso, orientamos o modelo usando o modelo de prompt de seleção de ferramentas inteligente para selecionar e usar uma ferramenta.

✅ Funciona com quase qualquer modelo

✅ Ótima maneira de desbloquear ferramentas com modelos básicos ou locais

❗ Não é tão confiável ou flexível quanto o modo nativo ao encadear ferramentas

🟢 Modo nativo (Chamada de função embutida)

Se o seu modelo suportar a chamada de função "nativa" (como GPT-4O ou GPT-3.5-Turbo-1106), você poderá usar esse modo poderoso para deixar o LLM decidir-em tempo real-quando e como chamar várias ferramentas durante uma única mensagem de bate-papo.

✅ Rápido, preciso e pode encadear várias ferramentas em uma resposta

✅ A experiência mais natural e avançada

❗ Requer um modelo que realmente suporta chamadas de função nativa

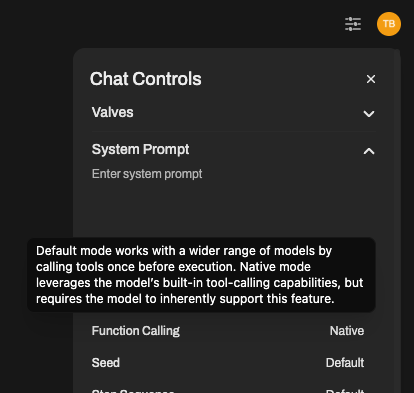

✳️ Como alternar entre os modos

Deseja ativar a chamada de função nativa em seus bate -papos? Aqui está como:

- Abra a janela de bate -papo com seu modelo.

- Clique em ⚙️Chat Controls> Params avançados.

- Procure a configuração de chamada de função e mude de padrão → nativo

É isso! Seu bate -papo agora está usando o verdadeiro suporte à ferramenta nativa (desde que o modelo o suporte).

➡️ Recomendamos o uso do GPT-4O ou outro modelo OpenAI para a melhor experiência de chamada de função nativa.

🔎 Alguns modelos locais podem reivindicar suporte, mas muitas vezes lutam com o uso de ferramentas preciso ou complexo.

💡 Resumo:

| Modo | Para quem é | Prós | Contras |

|---|---|---|---|

| Padrão | Qualquer modelo | Ampla compatibilidade, mais segura, flexível | Pode ser menos preciso ou mais lento |

| Nativo | GPT-4O, etc. | Corrente de ferramentas rápida, inteligente e excelente | Precisa de suporte adequado de chamada de função |

Escolha o que funciona melhor para a sua configuração - e lembre -se, você sempre pode ligar para os controles de bate -papo.

👏 E é isso - seu LLM agora sabe como e quando usar as ferramentas, de forma inteligente.

🧠 Resumo

As ferramentas são complementos que ajudam seu modelo de IA a fazer muito mais do que apenas um bate-papo. Desde responder a perguntas em tempo real até gerar imagens ou falar em voz alta-as ferramentas dão vida à sua IA.

- Visita:https://doc.nullcore.com.br/toolsPara descobrir novas ferramentas.

- Instale-os manualmente ou com um clique.

- Habilite -os por modelo a partir de modelos de espaço de trabalho ➡️.

- Use -os no bate -papo clicando ➕

Agora vá fazer o seu ai waaaaay mais inteligente 🤖✨