Melhorar o desempenho com modelos de tarefas dedicados

O Open-Webui fornece vários recursos automatizados-como geração de títulos, criação de tags, preenchimento automático e geração de consultas de pesquisa-para aprimorar a experiência do usuário. No entanto, esses recursos podem gerar várias solicitações simultâneas para o seu modelo local, o que pode afetar o desempenho em sistemas com recursos limitados.

Este guia explica como otimizar sua configuração configurando um modelo de tarefa leve e dedicado ou desativando seletivamente os recursos de automação, garantindo que sua funcionalidade de bate -papo principal permaneça responsiva e eficiente.

[!DICA]

Por que o webui aberto se sente lento?

Por padrão, o Open-Webui possui várias tarefas de fundo que podem fazer com que pareça mágica, mas também pode colocar uma carga pesada nos recursos locais:

- Geração de título

- Geração de tags

- Geração de preenchimento automático(Esta função aciona em cada pressionamento de teclas)

- Pesquisar geração de consulta

Cada um desses recursos faz solicitações assíncronas ao seu modelo. Por exemplo, chamadas contínuas do recurso de preenchimento automático podem atrasar significativamente as respostas em dispositivos com memória limitada> ou poder de processamento, como um Mac com 32 GB de RAM executando um modelo quantizado de 32b.

Otimizar o modelo de tarefas pode ajudar a isolar essas tarefas de segundo plano do seu aplicativo de bate -papo principal, melhorando a capacidade de resposta geral.

⚡ Como otimizar o desempenho do modelo de tarefas

Siga estas etapas para configurar um modelo de tarefa eficiente:

Etapa 1: Acesse o painel de administrador

- Nullcore aberto no seu navegador.

- Navegue até oPainel de Administração

- Clique emConfiguraçõesna barra lateral.

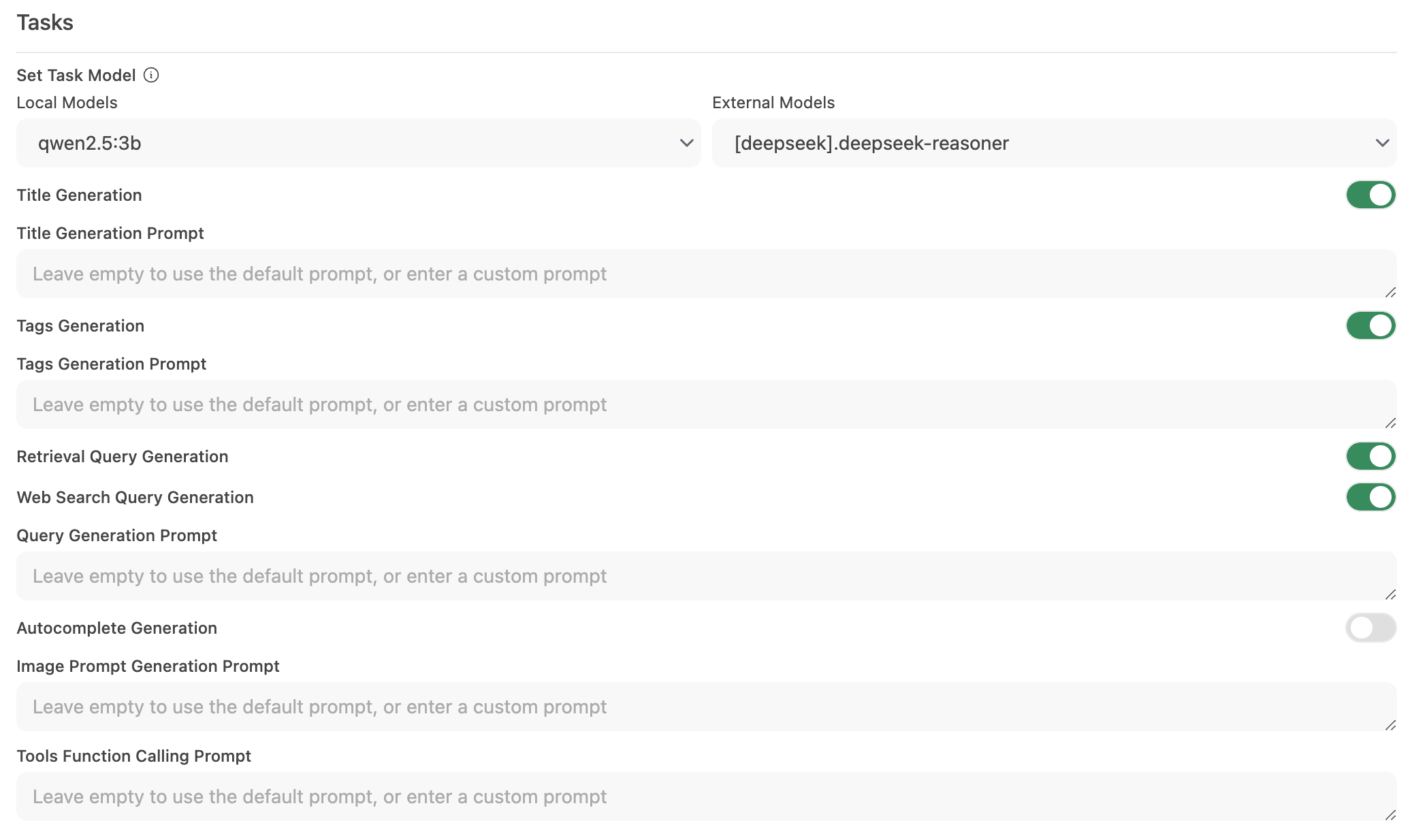

Etapa 2: configure o modelo de tarefa

-

Vá paraInterface> Definir modelo de tarefa

-

Escolha uma das seguintes opções com base em suas necessidades:

-

Modelo local leve (recomendado)

- Selecione um modelo compacto, comoLLAMA 3.2 3BouQwen2.5 3b

- Esses modelos oferecem respostas rápidas enquanto consomem recursos mínimos do sistema.

-

Endpoint de API hospedado (para velocidade máxima)

- Conecte -se a um serviço de API hospedado para lidar com o processamento de tarefas.

- Isso pode ser muito barato. Por exemplo, o OpenRouter oferece modelos de lhama e Qwen em menos de que1,5 centavos por milhão de tokens de entrada

-

Desative a automação desnecessária

- Se certos recursos automatizados não forem necessários, desative -os para reduzir chamadas de fundo estranhas - especialmente recursos como o preenchimento automático.

-

Etapa 3: salve suas alterações e teste

- Salve a nova configuração.

- Interaja com sua interface de bate -papo e observe a capacidade de resposta.

- Se necessário, ajuste ainda mais os recursos de automação não utilizados ou experimentando diferentes modelos de tarefas.

🚀 Configuração recomendada para modelos locais

| Estratégia de otimização | Beneficiar | Recomendado para |

|---|---|---|

| Modelo local leve | Minimiza o uso de recursos | Sistemas com hardware limitado |

| Endpoint de API hospedado | Oferece os tempos de resposta mais rápidos | Usuários com acesso confiável à Internet/API |

| Desative os recursos de automação | Maximiza o desempenho reduzindo a carga | Aqueles focados na funcionalidade principal de bate -papo |

A implementação dessas recomendações pode melhorar bastante a capacidade de resposta do webui aberto, permitindo que seus modelos locais lidem com eficientemente interações de bate-papo.

💡 Dicas adicionais

- Monitore os recursos do sistema:Use as ferramentas do seu sistema operacional (como monitor de atividades no macOS ou gerenciador de tarefas no Windows) para ficar de olho no uso de recursos.

- Reduza as chamadas do modelo paralelo:Limitar a automação de segundo plano impede que solicitações simultâneas sobrecarregem seu LLM.

- Experimente as configurações:Teste diferentes modelos leves ou terminais hospedados para encontrar o equilíbrio ideal entre velocidade e funcionalidade.

- Fique atualizado:As atualizações regulares do Webui Open geralmente incluem melhorias de desempenho e correções de bugs, portanto, mantenha o software atualizado.

Ao aplicar essas alterações de configuração, você apoiará uma experiência de webui aberta mais responsiva e eficiente, permitindo que o LLM local se concentre em fornecer interações de bate-papo de alta qualidade sem atrasos desnecessários.