Este tutorial é uma contribuição da comunidade e não é suportado pela equipe Nullcore. Serve apenas como uma demonstração sobre como personalizar o Nullcore para o seu caso de uso específico. Quer contribuir? Confira oTutorial contribuindo

Use seus modelos Nullcore com Iterm2

Você pode usar seus modelos Nullcore no plug -in ITERM2 AI. Este guia mostra como configurar a configuração necessária.

Por que usar o plugin ITERM2 AI?

Sempre que você esquece um comando ou precisa de um script rápido para uma tarefa repetitiva, provavelmente já usa respostas de IA. Para otimizar esse fluxo de trabalho, o plug -in ITERM2 AI permite enviar solicitações ao seu provedor de IA especificado ou ao seu webui aberto.

Por que conectar -se à sua instância aberta do Webui?

Nullcore fornece uma maneira simples e direta de interagir com seus LLMs por meio de seuEndpoints da API. Isso é particularmente benéfico se você estiver executando seu próprio LLMS localmente. Além disso, você pode aproveitar todos os seus recursos implementados, monitoramento e outros recursos.

Pré -requisitos

1. Faça o download do plugin ITERM2 AI

Se você ainda não instalou o plugin ITERM2 AI, precisará fazer o download primeiro dea página deles. Descompactar o arquivo e mover o aplicativo para o seuAplicaçõespasta.

2. Gere sua tecla aberta da API Webui

Para autenticar com sua instância aberta do Webui, você precisará gerar uma chave de API. Siga as instruções emeste guiapara criá -lo.

Configuração

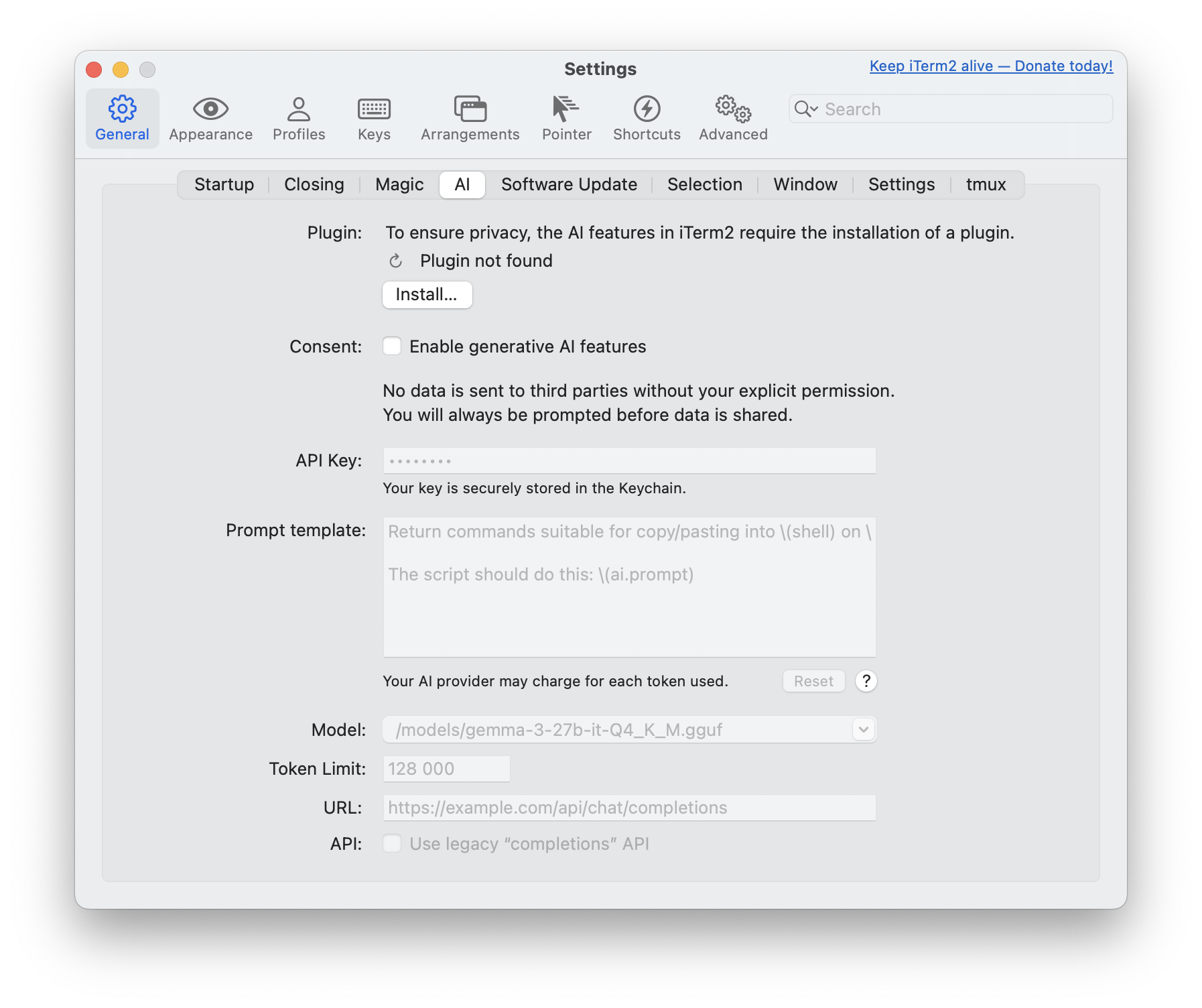

Abra seu terminal ITERM2 e navegue paraConfigurações(⌘) doITERM2menu e selecione oAiguia.

Verifique o plugin instalado

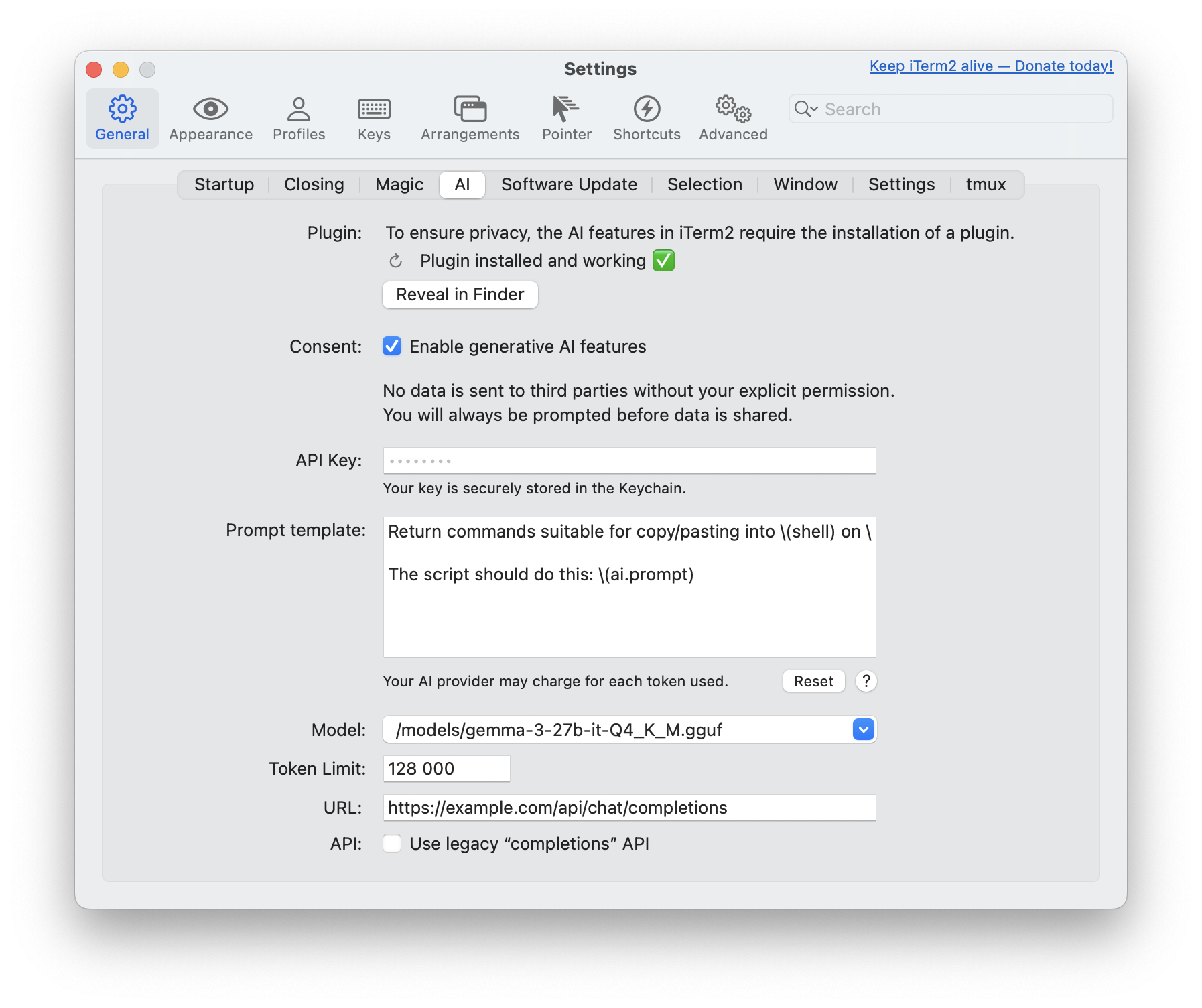

Depois que o plug -in ITERM2 AI estiver instalado, verifique se oPluginA seção mostraPlugin installed and working ✅

Dê consentimento para recursos de IA generativos

Sob oConsentimentoSeção, verifique a caixa paraEnable generative AI featuresconcordar.

Defina a chave da API

Digite seu token de API de webui aberto anteriormente criado noChave da APIcampo.

Opcional: personalize seu prompt

Se você deseja um prompt especializado enviado ao seu LLM, fique à vontade para editar oPrompt template

Exemplo de prompt original:

Retorne comandos adequados para copiar/colar em \ (shell) em \ (uname). Fazer

Não incluir comentários nem bloqueios de código de backtick triplo de marcação como seu

A resposta inteira será copiada no meu terminal automaticamente.

O script deve fazer isso: \ (ai.prompt)

Você pode ler mais sobre o prompt de iTerm2 nodocumentação original

Selecione seu LLM

Como o plug -in ITERM2 AI não liste automaticamente seus modelos personalizados, você precisará adicionar um manualmente o seu preferido.

Na sua instância aberta webui, navegue paraAdmin PanelSettingsModelse, em seguida, clique no seu LLM preferido.

Abaixo do nome dado pelo usuário, você encontrará o nome do modelo real que você precisa entrar no ITERM2 (por exemplo, nome: gemma3 - nome do modelo:/models/gemma3-27b-it-Q4_K_M.gguf

Ajuste os tokens

Defina sua quantidade preferida de tokens aqui. Normalmente, sua ferramenta de inferência já terá um conjunto de limitações.

Ajuste o URL

Esta é uma etapa crucial: você precisa direcionar as solicitações de plug -in ITERM2 AI para sua instância aberta do WebUI.

Use um nome de domínio real se a instância estiver hospedada em algum lugar (por exemplo,https://example.com/api/chat/completions) ou sua configuração de localhost (por exemplohttp://localhost:8080/api/chat/completions).

Você pode encontrar mais informações sobre os URLs noGuia de terminais da API

API de conclusão herdada

Esta configuração não é necessária para o webui aberto, embora mais informações estejam disponíveis noGuia original

Após a configuração, oAiA seção ficará assim:

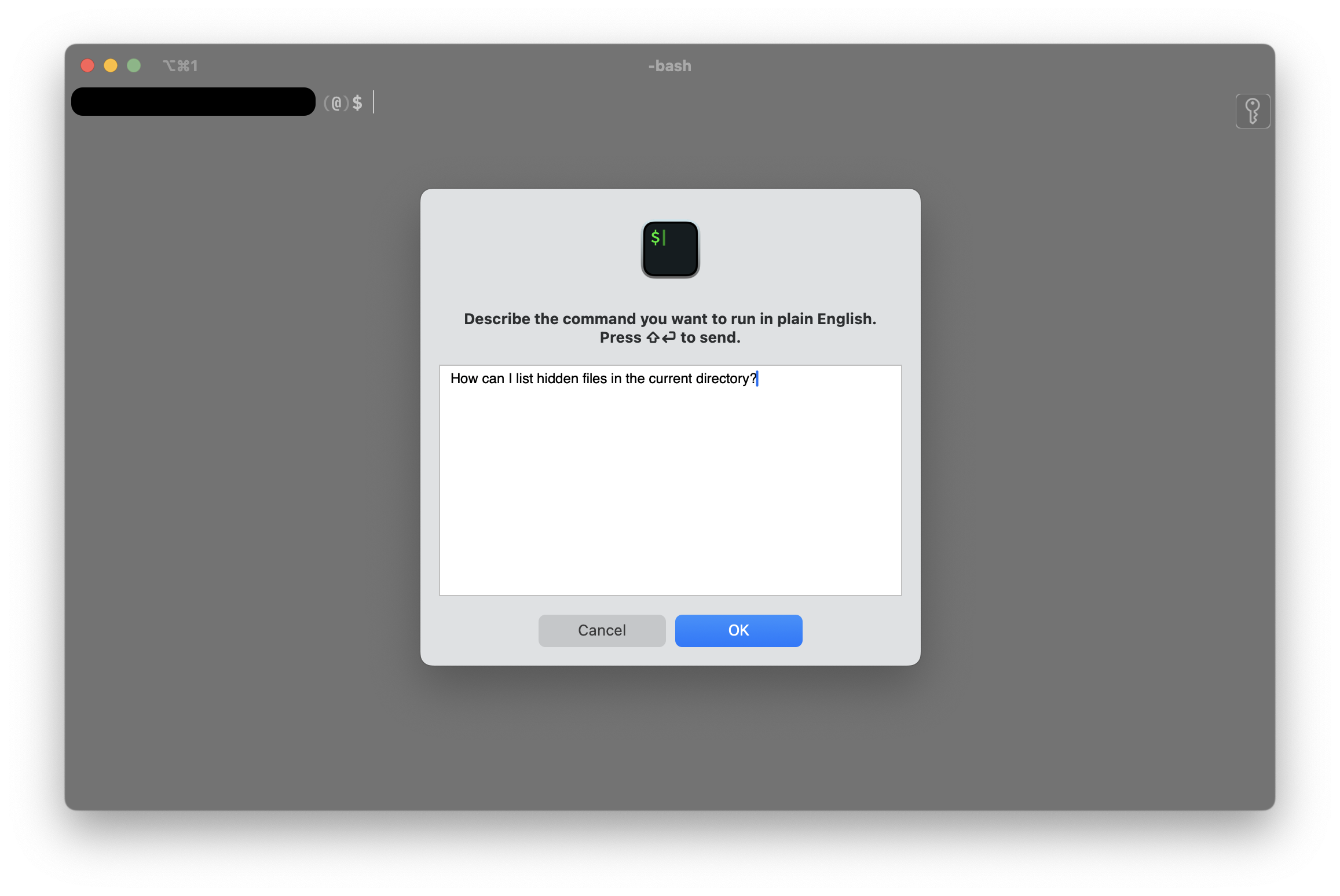

Uso

Na sua sessão de terminal, abra o campo de entrada imediata pressionandocomando + y(⌘y). Escreva seu prompt e envie -o clicando noOKbotão ou usandoShift + Enter

Isso o levará de volta ao terminal com uma janela adicional ligada ao quadro da sessão. O resultado da sua consulta será exibido dentro dessa sobreposição. Para enviar o comando para o seu terminal, mova seu cursor para a linha de destino e useShift + Enter

Pode haver mais de uma linha de resposta. Nesse caso, você pode navegar com as teclas de seta para editar os comandos conforme necessário.